Lorsque vous demandez à un modèle d’IA de créer une publication sur les réseaux sociaux ou de générer un graphique d’animal inspiré par Picasso, cela entraîne un coût énergétique faible mais quantifiable, accompagné d’émissions rejetées dans l’atmosphère. Alors que chaque requête individuelle consomme généralement moins d’énergie que l’utilisation brève d’une friteuse, l’effet peut sembler négligeable. Cependant, à mesure que de plus en plus de personnes comptent sur les outils d’IA, ces impacts cumulatifs deviennent de plus en plus importants. Selon Morgan Stanley, la demande d’énergie générée par l’IA augmentera en moyenne de 70 % par an d’ici 2027, principalement en raison de la croissance des centres de données dépendant de l’IA.

La dépendance croissante de l’IA à l’égard de procédés énergivores ne façonne pas seulement l’infrastructure à une échelle sans précédent, mais aussi à un moment où la durabilité mondiale est de plus en plus remise en question. À mesure que les systèmes d’IA se généralisent, leur consommation d’énergie s’accélère, ce qui soulève des questions sur les implications à long terme pour l’environnement, les ressources énergétiques et la technologie elle-même. Des centres de données aux modèles d’inférence, les besoins en énergie de l’IA sont sur le point d’exploser ces prochaines années et les experts en sont conscients.

Quelques-uns des meilleurs esprits du secteur se sont réunis à Cambridge, dans l’État du Massachusetts, du 5 au 7 mai 2025, à l’EmTech AI Conference, pour discuter des implications de la durabilité de l’intelligence artificielle. Les membres de la rédaction du célèbre MIT Technology Review ont exploré la portée de l’impact énergétique de l’IA, sa direction et pourquoi il est impératif que les décisions prises aujourd’hui équilibrent l’innovation et la responsabilité. En fin de compte, ces experts mettent en garde contre le fait que nous sommes à un carrefour critique qui déterminera si les futures innovations en matière d’IA pourront coexister avec les efforts mondiaux pour lutter contre le changement climatique.

MIT Technology Review de gauche à droite : Will Douglas Heaven, rédacteur en chef adjoint ; James O’Donnell, journaliste IA ; Mat Honan, rédacteur en chef

La demande croissante en énergie de l’IA

L’utilisation de l’énergie par l’IA provient de deux opérations principales : l’entraînement des modèles et les tâches d’inférence. L’entraînement de modèles d’IA complexes, tels que les grands modèles de langage et les systèmes de génération d’images tels que ChatGPT, Gemini, Llama et Claude, nécessite une puissance de calcul et des ressources énergétiques massives. Les processus d’entraînement des modèles avancés peuvent nécessiter des semaines, voire des mois, pour faire fonctionner des flottes de GPU haute performance, traitant de vastes ensembles de données. Les coûts carbone de ce processus sont importants et ne représentent qu’une partie du défi.

L’inférence, l’étape où les modèles d’IA répondent aux entrées ou aux demandes des utilisateurs (par exemple, la génération de texte, la réponse aux requêtes de recherche ou la création d’œuvres d’art), devrait consommer une part encore plus importante d’énergie dans un avenir proche. Contrairement à l’entraînement, l’inférence se fait à la demande et à grande échelle. Chaque interaction avec un système d’IA, qu’il s’agisse d’un assistant personnel comme ChatGPT ou d’un outil de conception visuelle, nécessite des ressources informatiques, ce qui crée un fardeau énergétique cumulatif à mesure que ces interactions se multiplient.

« Nous nous dirigeons vers un monde où de multiples modèles d’IA répondent à des milliards de requêtes quotidiennes, et ces inférences sont déjà un gouffre énergétique massif et croissant », a expliqué Mat Honan, rédacteur en chef de MIT Technology Review. “Et si nous voulons suivre la demande prévue, nous allons avoir besoin de beaucoup plus de puissance que celle que nous avons actuellement.”

L’ampleur de ce changement ne peut être sous-estimée : à mesure que les outils d’IA se généralisent dans les systèmes grand public et d’entreprise, l’énergie utilisée pour alimenter ces outils continuera de croître, soulevant des questions complexes sur la quantité d’énergie que notre infrastructure peut gérer et ses implications pour l’environnement. Alors, d’où proviendra cette énergie ?

Quelle quantité d’énergie est-elle nécessaire ?

Établir la quantité d’énergie nécessaire pour répondre aux besoins futurs de l’IA est compliqué. Les experts ne peuvent que spéculer.

“Je ne peux pas insister là-dessus, nous ne savons vraiment rien sur la quantité d’énergie utilisée lorsque vous posez une question ou générez une vidéo”, a déclaré James O’Donnell, journaliste IA de la MIT Technology Review. “Nous faisons des estimations sur la quantité d’énergie utilisée spécifiquement dans l’inférence, et il existe toutes sortes de moyens de le faire, mais c’est tout à fait indirect.”

Et c’est au niveau fonctionnel, au niveau des centres de données, que l’on essaie encore de comprendre quelles sources d’énergie vont alimenter cette révolution de l’IA.

Le rôle des centres de données : nourrir la consommation d’énergie de l’IA

Les centres de données sont le pilier des systèmes d’IA. Ces installations tentaculaires abritent les serveurs et processeurs qui permettent aux modèles d’IA de fonctionner. Cependant, leur échelle, leur complexité et leur consommation d’énergie suscitent l’alarme à l’échelle mondiale.

Prenons l’exemple du Nevada, où des géants de la tech comme Google et Apple ont construit d’immenses centres de données dans ce qui est déjà l’un des États les plus secs d’Amérique. Ces installations consomment des quantités massives d’énergie pour maintenir des serveurs haute performance à des températures optimales. Les technologies de refroidissement sont vitales dans ces emplacements désertiques, nécessitant une utilisation d’eau et une puissance significatives pour maintenir les opérations. Près de la moitié des besoins en énergie d’un centre de données proviennent de la nécessité de le refroidir.

Centre de données solaire d’Apple, Nevada

Le problème ne se limite pas au Nevada. En Louisiane, Meta construit son plus grand centre de données à ce jour, un projet conçu pour soutenir ses ambitions en matière d’IA. Cependant, cette entreprise s’appuie fortement sur l’énergie des centrales au gaz naturel, compromettant ainsi les objectifs en matière d’énergie propre. Ces développements révèlent des contradictions troublantes : bien que les entreprises reconnaissent l’importance de la durabilité, elles restent attachées à des sources d’énergie qui perpétuent la dépendance aux énergies fossiles. “Les énergies renouvelables, pour la plupart, ne disposent pas de la cohérence nécessaire qu’un centre de données requiert”, a souligné Honan.

Une augmentation de la demande en électricité entraînée par l’IA met également une pression supplémentaire sur les réseaux électriques, accélérant involontairement la construction d’installations énergétiques à base de gaz naturel. Cette dépendance aux énergies fossiles, en partie due aux besoins en électricité de l’IA, constitue un sérieux défi pour les objectifs climatiques, les industries luttant pour mettre en place des solutions renouvelables assez rapidement pour répondre à la demande.

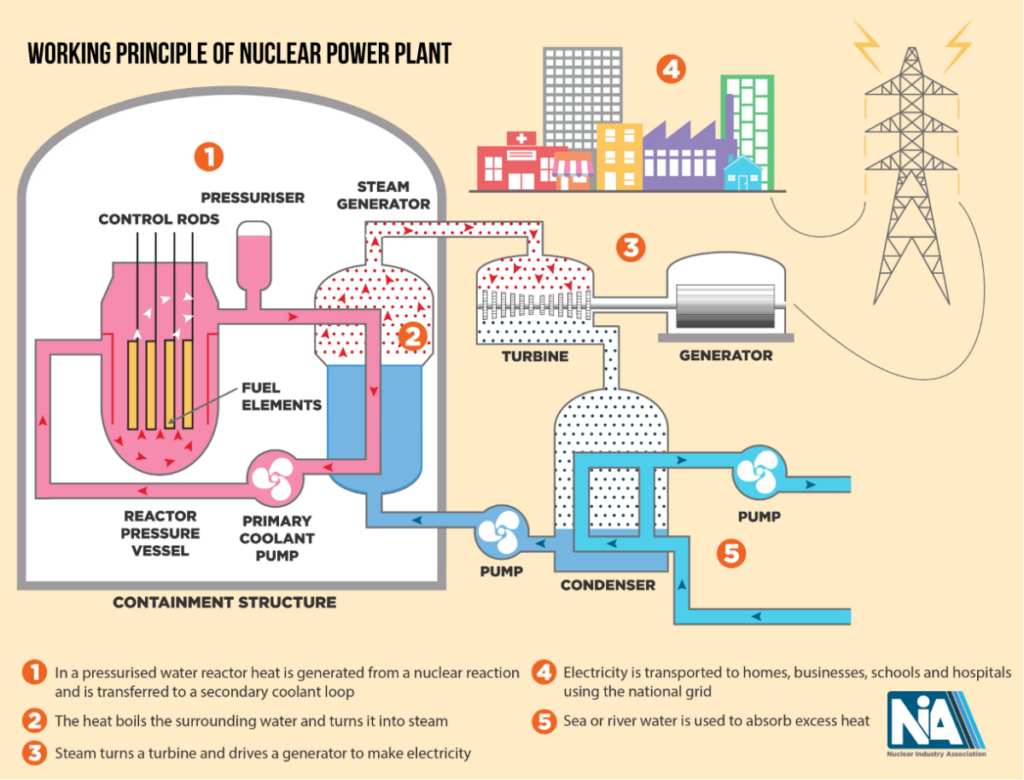

L’énergie nucléaire peut-elle résoudre la crise énergétique de l’IA ?

Pour répondre à la demande croissante en énergie engendrée par l’IA, de nombreuses personnes se tournent vers l’énergie nucléaire comme solution potentielle. Considérée comme une alternative plus propre aux énergies fossiles, l’énergie nucléaire offre une source d’électricité stable et fiable qui pourrait, en théorie, alimenter de manière durable les futures opérations d’IA. Cependant, il existe des obstacles significatifs à cette transition. “Bien que le nucléaire puisse sembler formidable, cela prend des années, parfois une décennie ou plus, pour mettre en service une nouvelle centrale”, a fait remarquer Honan.

De plus, des obstacles politiques, la résistance du public et des coûts élevés compliquent davantage l’adoption de l’énergie nucléaire. Par conséquent, il faudra probablement des années, voire des décennies, avant que l’énergie nucléaire ne puisse contribuer de manière significative à alimenter la croissance de l’IA à grande échelle. Même si le concept est prometteur, il est loin de constituer une solution immédiate au dilemme énergétique de l’IA.

https://contributor-assets.benzinga.com/wp-content/uploads/2025/06/02140416/NIA-300×229.png 300w, https://contributor-assets.benzinga.com/wp-content/uploads/2025/06/02140416/NIA-768×585.png 768w, https://contributor-assets.benzinga.com/wp-content/uploads/2025/06/02140416/NIA.png 1200w” sizes=”(max-width: 1024px) 100vw, 1024px” />

https://contributor-assets.benzinga.com/wp-content/uploads/2025/06/02140416/NIA-300×229.png 300w, https://contributor-assets.benzinga.com/wp-content/uploads/2025/06/02140416/NIA-768×585.png 768w, https://contributor-assets.benzinga.com/wp-content/uploads/2025/06/02140416/NIA.png 1200w” sizes=”(max-width: 1024px) 100vw, 1024px” />Source : site web de la Nuclear Innovation Alliance

Les entreprises investissent massivement pour explorer les options nucléaires dans le cadre de leurs plans à long terme pour décarboniser l’infrastructure de données, en particulier à l’étranger. La première centrale nucléaire de Chine a été connectée au réseau en 1991, et en quelques décennies seulement, le pays a développé le troisième plus grand parc nucléaire au monde, derrière la France et les États-Unis. Cette année, la Chine devrait mettre en service quatre grands réacteurs, avec plusieurs autres en cours de commissionnement en 2026.

Pourquoi le problème énergétique de l’IA est-il important

Actuellement, l’empreinte énergétique de l’IA constitue une partie relativement faible de la consommation mondiale d’électricité. Cependant, sa trajectoire est préoccupante. Les analystes mettent en garde contre le fait que si l’on ne freine pas la consommation croissante d’énergie de l’IA, cela pourrait avoir un effet en cascade sur les plans d’électrification plus larges et les efforts pour lutter contre le changement climatique. Les besoins en énergie des centres de données représentent un microcosme des défis plus larges d’électrification auxquels l’humanité doit faire face : à mesure que la société adopte de nouvelles technologies qui reposent sur l’électricité, il devient de plus en plus essentiel de garantir des pratiques énergétiques durables.

De plus, les besoins en énergie de l’IA exposent les inégalités existantes en matière d’allocation des ressources. Les communautés qui hébergent des centres de données énergivores peuvent subir des répercussions environnementales disproportionnées, notamment des pénuries d’eau et des émissions plus élevées associées à la production d’énergie locale. Cela crée une impérative morale pour les décideurs politiques et les entreprises d’adopter des stratégies équitables et durables.

Plaidoyer en faveur de l’optimisme : vers une IA économe en énergie

Malgré ces défis, il y a des raisons d’être optimiste quant à l’avenir énergétique de l’IA. Les technologies et innovations émergentes pourraient réduire considérablement l’intensité énergétique des systèmes d’IA dans les années à venir. Des améliorations logicielles et matérielles, y compris le développement de processeurs plus efficaces, sont déjà en cours.

“Du côté logiciel, il y aura toujours des améliorations dans la façon dont les modèles d’IA sont